Inflection AI, les créateurs de PI AI Personal Assistant, ont annoncé la création d’un nouveau grand modèle de langage puissant appelé Inflection-2 qui surpasse le modèle de langage PaLM de Google sur une gamme d’ensembles de données d’analyse comparative.

Assistant personnel Pi

Pi est un assistant personnel disponible sur le Web et sous forme d’application pour les appareils mobiles Android et Apple.

Il peut également être ajouté en tant que contact dans WhatsApp et accessible via les messages directs Facebook et Instagram.

Pi est conçu pour être un assistant chatbot capable de répondre aux questions, de rechercher des produits, des sciences ou des produits et il peut fonctionner comme un compagnon de discussion qui dispense des conseils.

Le nouveau LLM sera intégré à PI AI peu après avoir subi des tests de sécurité.

Grand modèle de langage Inflection-2

Inflection-2 est un grand modèle de langage qui surpasse le modèle PaLM 2 Large de Google, qui est actuellement le modèle le plus sophistiqué de Google.

Inflection-2 a été testé sur plusieurs benchmarks et comparé à PaLM 2 et LLaMA 2 de Meta et à d’autres grands modèles de langage (LLM).

Par exemple, PaLM 2 de Google a à peine dépassé Inflection-2 sur le corpus Natural Questions, un ensemble de données de questions du monde réel.

PaLM 2 a obtenu un score de 37,5 et Inflection-2 un score de 37,3, les deux surperformant LLaMA 2, qui a obtenu un score de 33,0.

MMLU – Compréhension massive du langage multitâche

Inflection AI a publié les scores d’analyse comparative sur l’ensemble de données MMLU, conçu pour tester les LLM d’une manière similaire aux tests sur les humains.

Le test porte sur 57 matières en STEM (sciences, technologie, ingénierie et mathématiques) et un large éventail d’autres matières comme le droit.

Le but de l’ensemble de données est d’identifier où le LLM est le plus fort et où il est faible.

Selon le document de recherche pour cet ensemble de données d’analyse comparative :

«Nous proposons un nouveau test pour mesurer la précision multitâche d’un modèle de texte.

Le test couvre 57 tâches, notamment les mathématiques élémentaires, l’histoire des États-Unis, l’informatique, le droit, etc.

Pour atteindre une grande précision à ce test, les modèles doivent posséder une connaissance approfondie du monde et une capacité à résoudre des problèmes.

Nous constatons que même si les modèles les plus récents ont une précision proche du hasard, le plus grand modèle GPT-3 améliore le hasard de près de 20 points de pourcentage en moyenne.

Cependant, pour chacune des 57 tâches, les meilleurs modèles nécessitent encore des améliorations substantielles avant de pouvoir atteindre une précision de niveau expert.

Les modèles ont également des performances déséquilibrées et ne savent souvent pas quand ils se trompent.

Pire encore, ils ont encore une précision quasi aléatoire sur certains sujets socialement importants tels que la moralité et le droit.

En évaluant de manière exhaustive l’étendue et la profondeur de la compréhension académique et professionnelle d’un modèle, notre test peut être utilisé pour analyser des modèles dans de nombreuses tâches et pour identifier des lacunes importantes.

Voici les scores de l’ensemble de données d’analyse comparative MMLU, du plus faible au plus fort :

- LLaMA 270b 68,9

- GPT-3,5 70,0

- Grok-1 73,0

- PaLM-2 Grand 78,3

- Claude-2 _CoT 78.5

- Inflexion-2 79,6

- GPT-4 86,4

Comme on peut le voir ci-dessus, seul GPT-4 obtient des scores supérieurs à Inflection-2.

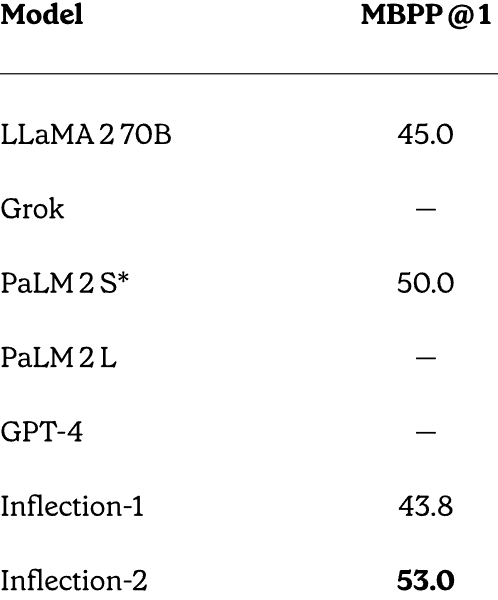

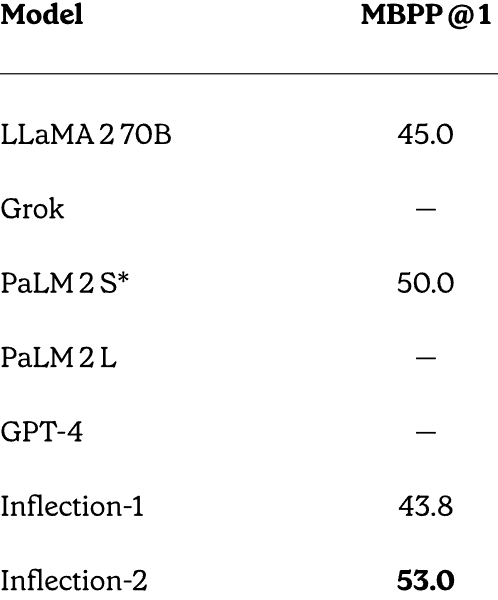

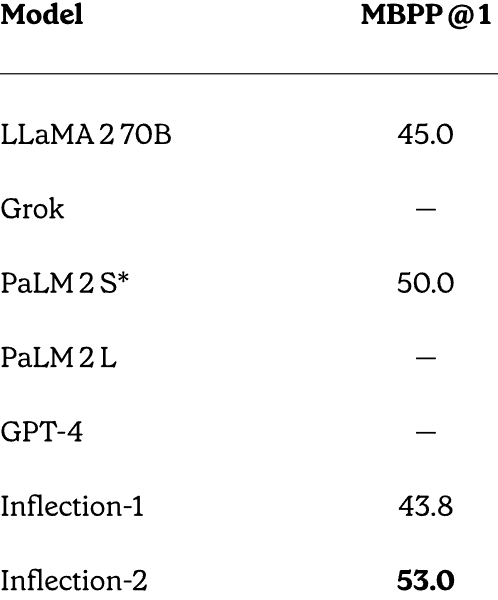

MBPP – Performance du code et du raisonnement mathématique

Inflection AI a effectué une comparaison directe entre GPT-4, PaLM 2, LLaMA et Inflection-2 sur les tests de mathématiques et de raisonnement codé et a étonnamment bien réussi étant donné qu’il n’était pas spécifiquement formé pour résoudre des problèmes mathématiques.

L’ensemble de données d’analyse comparative utilisé est appelé MBPP (Mostly Basic Python Programming). Cet ensemble de données comprend plus de 1 000 problèmes de programmation Python issus du crowdsourcing.

Ce qui rend les scores particulièrement remarquables, c’est qu’Inflection AI a été testé par rapport à PaLM-2S, qui est une variante d’un grand modèle de langage spécialement affiné pour le codage.

Scores MBPP :

- LLaMA-2 70B : 45,0

- PaLM-2S : 50,0

- Inflexion-2 : 53,0

Capture d’écran des scores MBPP complets

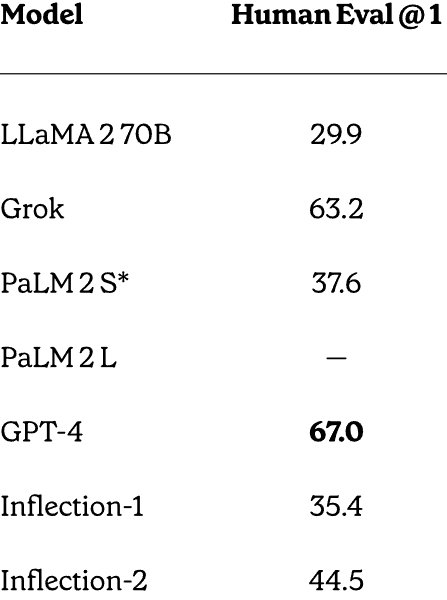

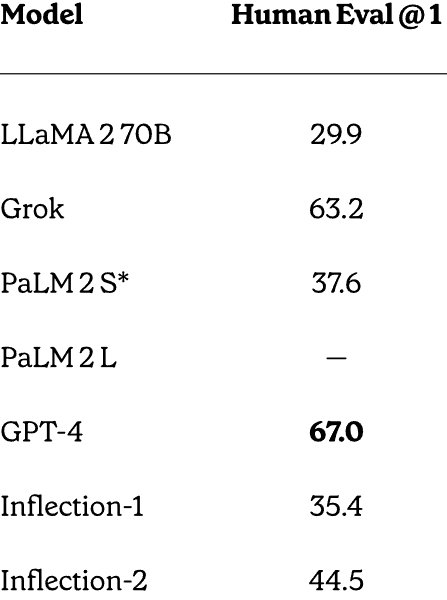

Test de l’ensemble de données HumanEval

Inflection-2 a également surpassé PaLM-2 sur l’ensemble de données de résolution de problèmes HumanEval développé et publié par OpenAI.

Hugging Face décrit cet ensemble de données :

« L’ensemble de données HumanEval publié par OpenAI comprend 164 problèmes de programmation avec une signature de fonction, une docstring, un corps et plusieurs tests unitaires.

Ils ont été rédigés à la main pour garantir qu’ils ne seront pas inclus dans l’ensemble de formation des modèles de génération de code.

Les problèmes de programmation sont écrits en Python et contiennent du texte naturel anglais dans les commentaires et les docstrings.

L’ensemble de données a été élaboré à la main par des ingénieurs et des chercheurs d’OpenAI.

Voici les scores :

- LLaMA-2 70B : 29,9

- PaLM-2S : 37,6

- Inflexion-2 : 44,5

- GPT-4 : 67,0

Comme on peut le voir ci-dessus, seul GPT-4 a obtenu un score supérieur à Inflection-2. Pourtant, il convient de noter une fois de plus qu’Inflection-2 n’a pas été optimisé pour résoudre ce type de problèmes, ce qui fait de ces résultats une réussite impressionnante.

Capture d’écran des scores complets de HumanEval

Inflection AI explique pourquoi ces scores sont significatifs :

«Résultats aux tests de mathématiques et de codage.

Bien que notre objectif principal pour Inflection-2 n’était pas d’optimiser ces capacités de codage, nous constatons de solides performances sur les deux grâce à notre modèle pré-entraîné.

Il est possible d’améliorer encore les capacités de codage de notre modèle en affinant un ensemble de données contenant beaucoup de code.

Un LLM encore plus puissant arrive

L’annonce d’Inflection AI indiquait qu’Inflection-2 avait été formé sur 5 000 GPU NVIDIA H100. Ils prévoient de former un modèle encore plus grand sur un cluster de 22 000 GPU, soit plusieurs commandes supérieures à celles du cluster de 5 000 GPU sur lequel Inflection-2 a été formé.

Google et OpenAI sont confrontés à une forte concurrence de la part des startups fermées et open source. Inflection AI rejoint les premiers rangs des startups avec une puissante IA en cours de développement.

L’assistant personnel PI est une plateforme d’IA conversationnelle dotée d’une technologie sous-jacente de pointe avec la possibilité de devenir encore plus puissante que d’autres plateformes dont l’accès est payant.

Lire l’annonce officielle :

Inflexion-2 : la prochaine étape

Visitez l’assistant personnel PI en ligne

Image en vedette par Shutterstock/Malchevska